怎么禁止搜索引擎抓取网站页面,robots.txt文件制作的制作

怎么禁止搜索引擎抓取网站页面,robots.txt文件制作的制作

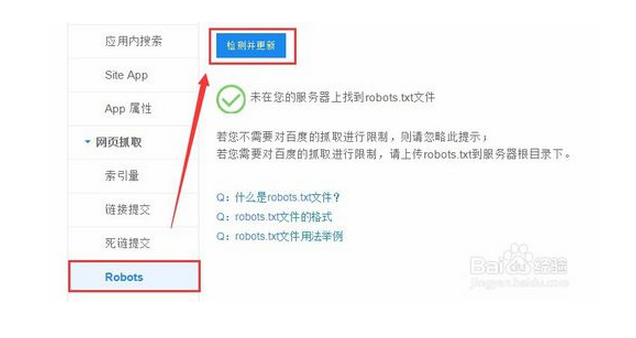

一、什么是Robots文件。Robots.txt文件是我们用来规范搜索引擎蜘蛛在索引网站时的索引范围,可以防止搜索引擎索引我们网站的私密文件。

注意事项:

1) 必须放在根目录下。

2) 文件名必须全部小写。

3) 如果允许全部抓取,也需要建立一个空的Robots.txt文件。

4) Robots.txt禁止的文件仍然有可能出现在搜索结果中。如需完全禁止需要用Meta Robots属性。

5) Robots只是一种规则,需要搜索引擎的配合。如若搜索引擎不遵守则无意义。 二、Robots.txt文件的语法规则。Robots.txt中的记录是以空行来分开的,每行的格式:“<field>:<optionalspace><value><optionalspace>",<field>表示定义域,<optionalspace>表示开放空格,<value>表示定义域值。<field>定义域有三种:

二、Robots.txt文件的语法规则。Robots.txt中的记录是以空行来分开的,每行的格式:“<field>:<optionalspace><value><optionalspace>",<field>表示定义域,<optionalspace>表示开放空格,<value>表示定义域值。<field>定义域有三种:

1)User-agent该项定义域用来描述搜索引擎名称。常见搜索引擎名称:

Baiduspider 百度

Scooter Vista

ia_archiver Alexa

Googlebot 谷歌

FAST-WebCrawler Fast

MSNBOT Msn

2)Disallow该项定义域用来描述希望不被索引的URL路径。

3)Allow该项定义域用来描述可以被索引的URL路径(由于缺省值是允许索引所以该项定义域会很少使用到)。Disallow与Allow这两定义域的域值可以是一条完整路径也可以是路径的非空前缀。

三、robots.txt文件具体写法。robots.txt文件包含2个域,“User-agent:”和“Disallow:”,每条指令独立一行。

(1)User-agent:指定允许哪些蜘蛛抓取,如果给出参数,则只有指定的蜘蛛能够抓取;如值为通配符“*”号,代表允许所有蜘蛛抓取。如:

User-agent: Googlebot

只允许Google的蜘蛛抓取;User-agent: *允许所有蜘蛛抓取。注意:User-agent必须出现在第一行(有意义的行,注释除外),首先声明用户代理。

(2)Disallow:指定禁止蜘蛛抓取的目录或文件,如:

Disallow: /help.php

禁止抓取根目录下help.php文件;

Disallow: /admin/禁止抓取根目录下的admin子目录中任何内容;

Disallow:

值为空时,表示不限制,蜘蛛可以抓取站内任何内容。

如果需要指定多个目录或文件,可以用多个“Disallow: 文件或目录名”来指定,但必须每一项单独一行(例如google的robots.txt就很夸张)。

四、Robots.txt文件的具体实例用法。

例1. 禁止所有搜索引擎访问网站的任何部分User-agent: * Disallow: /

例2. 允许所有的robot访问网站的任何部分User-agent: * Disallow:

例3. 仅禁止Baiduspider访问您的网站User-agent: Baiduspider Disallow: /

例4. 仅允许Baiduspider访问您的网站User-agent: Disallow: User-agent: * Disallow: /

例5. 禁止spider访问特定目录User-agent: * Disallow: /cgi-bin/ Disallow: /tmp/ Disallow: /data/

深圳网站建设【创强科技】专业从事:网站建设、营销型网站建设、网站设计、网站开发、响应式网站建设开发、供空间域名、虚拟主机、服务器托管、网站维护等基础服务。

我们:专业专注.用心服务.不求第一.但求最好!

创强科技:佰仟之德;达您所愿!

你的满意,你的肯定.就是对我们的认可,让我们携手共赢!!!

请联系我们;服务热线:15014038180

余经理:QQ:1910338799

地址:深圳市龙华新区民治大道218号沙元埔大厦13楼1318室(民治地铁站D出口对面)

以上【 怎么禁止搜索引擎抓取网站页面,robots.txt文件制作的制作 】的内容由创强科技(http://www.yxwzsj.com)为您提供,本文网址 : http://www.yxwzsj.com/wzjszsfx/97.html ,转载请注明出处!更多有关深圳网站建设,微信营销、电商平台建设、系统开发等互联网应用服务都可以联系我们。热线:13689590100